接続から認知へ

エッジAIの能力を拡張し、

高度でリアルタイムなビジョン処理および分析を実現

Extending Edge AI capabilities

into high-end, real-time vision

processing & analytics

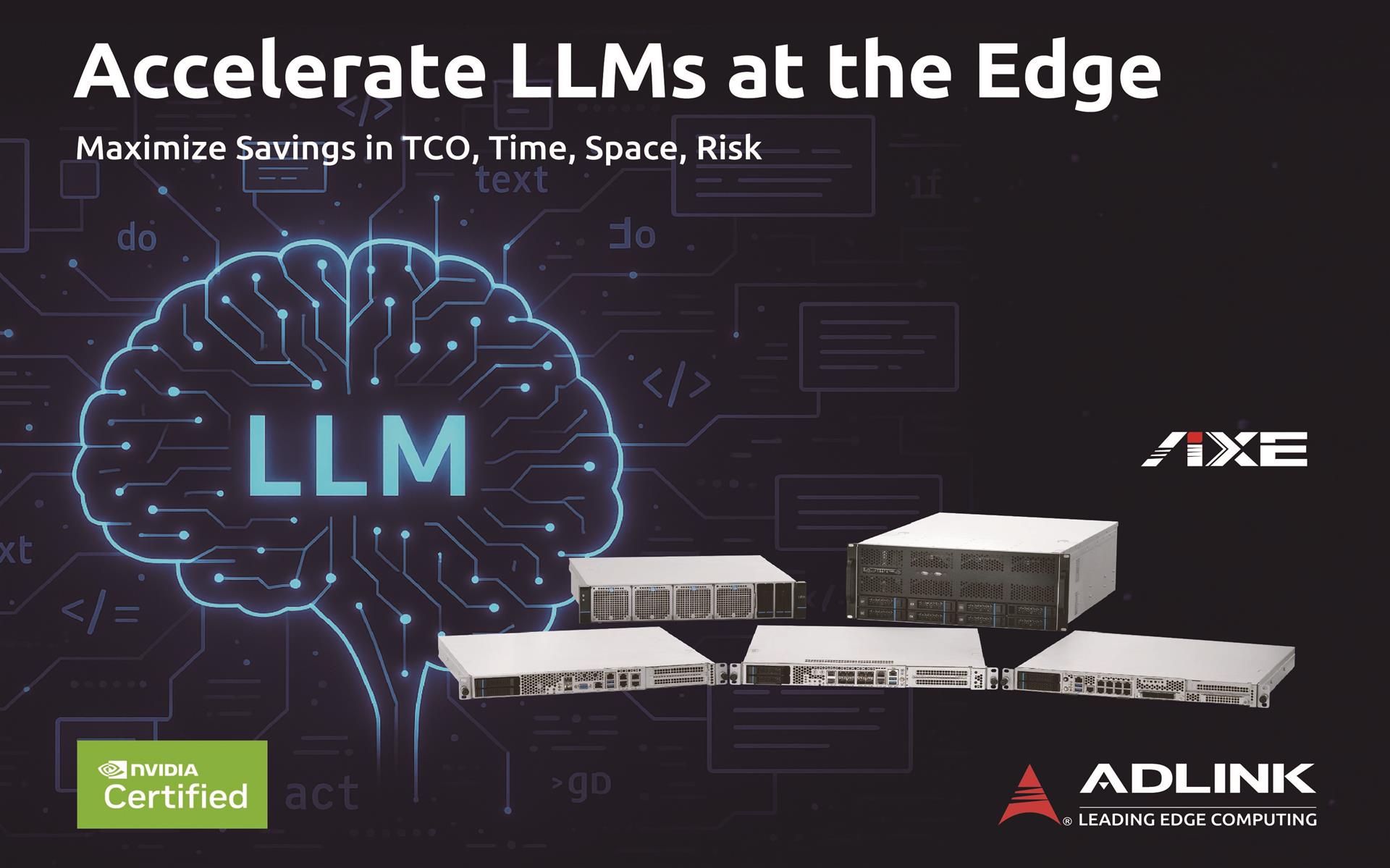

エンタープライズAIが中央集約型クラウドからオンプレミスのエッジコンピューティングへと移行する中、高性能・高柔軟性・高セキュリティを備えたGPUサーバへの需要が高まっています。ADLINKのAXEシリーズは、エッジでのフルAI処理を可能にすることでこのニーズに応え、クラウドに依存することなく、最大限のプライバシーを確保しながらリアルタイムのインサイトを提供します。

AXEシリーズの多くのサーバは NVIDIA認定を取得しており、 AIワークロードに対して信頼性・互換性・最適化されたパフォーマンスを保証します。厳格なテストを通過しており、スムーズな運用、迅速な導入、そして高い安定性を実現します。

さらにAXEシリーズは、ADLINKのエッジAI機能を高度なリアルタイム映像処理および分析へと拡張します。VLAワークロードにも対応し、企業が最も要求の厳しい映像データストリームを、比類のない精度とスピードで処理できるよう支援します。

AI対応アーキテクチャでインテリジェンスを加速

エッジネイティブ

デザイン

Compact, industrial-grade reliability with an extended product lifecycle

GPU

最適化ハブ

Precision-tuned power and thermal design for peak accelerator throughput

AI対応

プラットフォーム

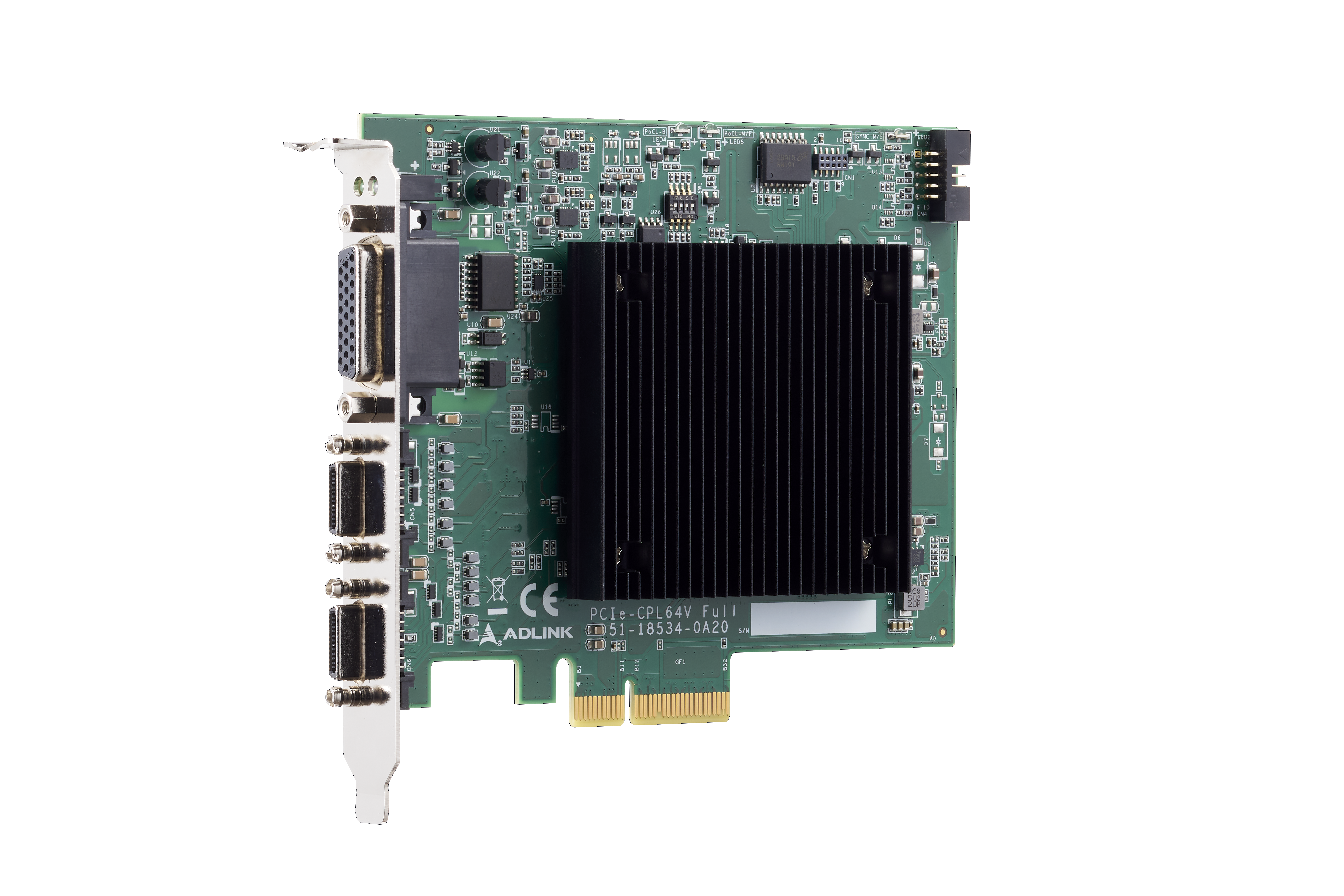

Certified integration for GPUs, accelerators, and frame grabbers