從連結到智慧決策

Extending Edge AI capabilities into high-end,

real-time vision processing & analytics

將邊緣 AI 能力

延伸至高階即時視覺處理與分析

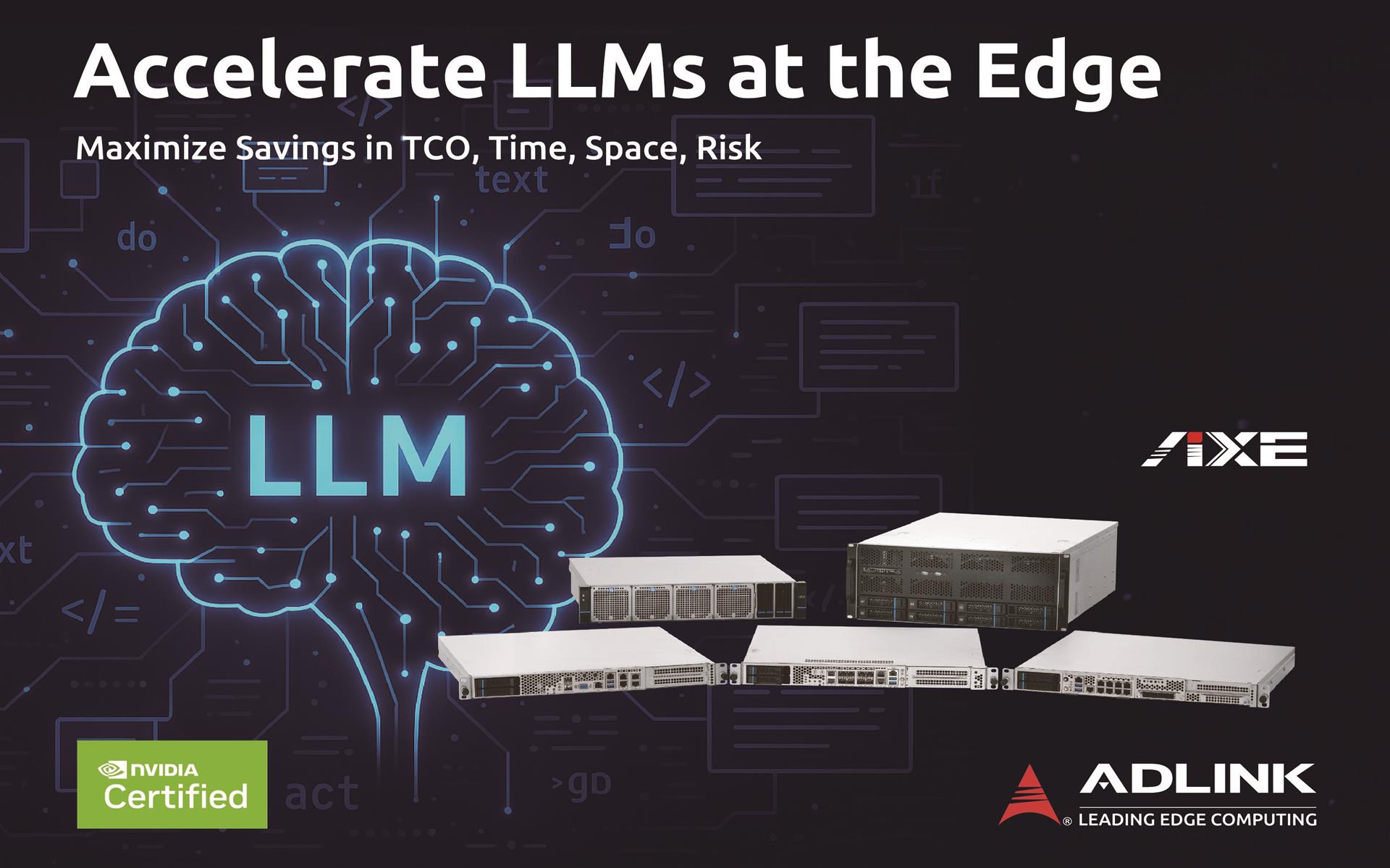

隨著企業 AI 應用由集中式雲端架構轉向在地化邊緣運算,市場對於高效能、彈性且安全的 GPU 伺服器需求日益提升。ADLINK AXE 系列正是為此而生,實現完整的邊緣端 AI 運算能力,在無需依賴雲端的前提下,提供即時洞察與最高等級的資料隱私保護。

多款 AXE 系列伺服器通過 NVIDIA 認證,確保 AI 工作負載的可靠性、相容性與最佳化效能。產品皆通過嚴格測試驗證,可實現快速部署、穩定運作與無縫整合。

AXE 系列進一步將 ADLINK 的邊緣 AI 能力延伸至高階即時視覺處理與分析領域,包含 VLA(Vision-Language-Action)工作負載,協助企業以卓越的精準度與速度,處理最具挑戰性的視覺資料流,全面釋放高效能 AI 潛能。

以 AI 就緒架構,加速智慧運算落地

邊緣

原生設計

精巧體積與工業級可靠性兼具,並提供長期產品供貨支援

GPU

優化運算中樞

精準調校的電源與散熱設計,確保加速器達到最佳運算吞吐效能

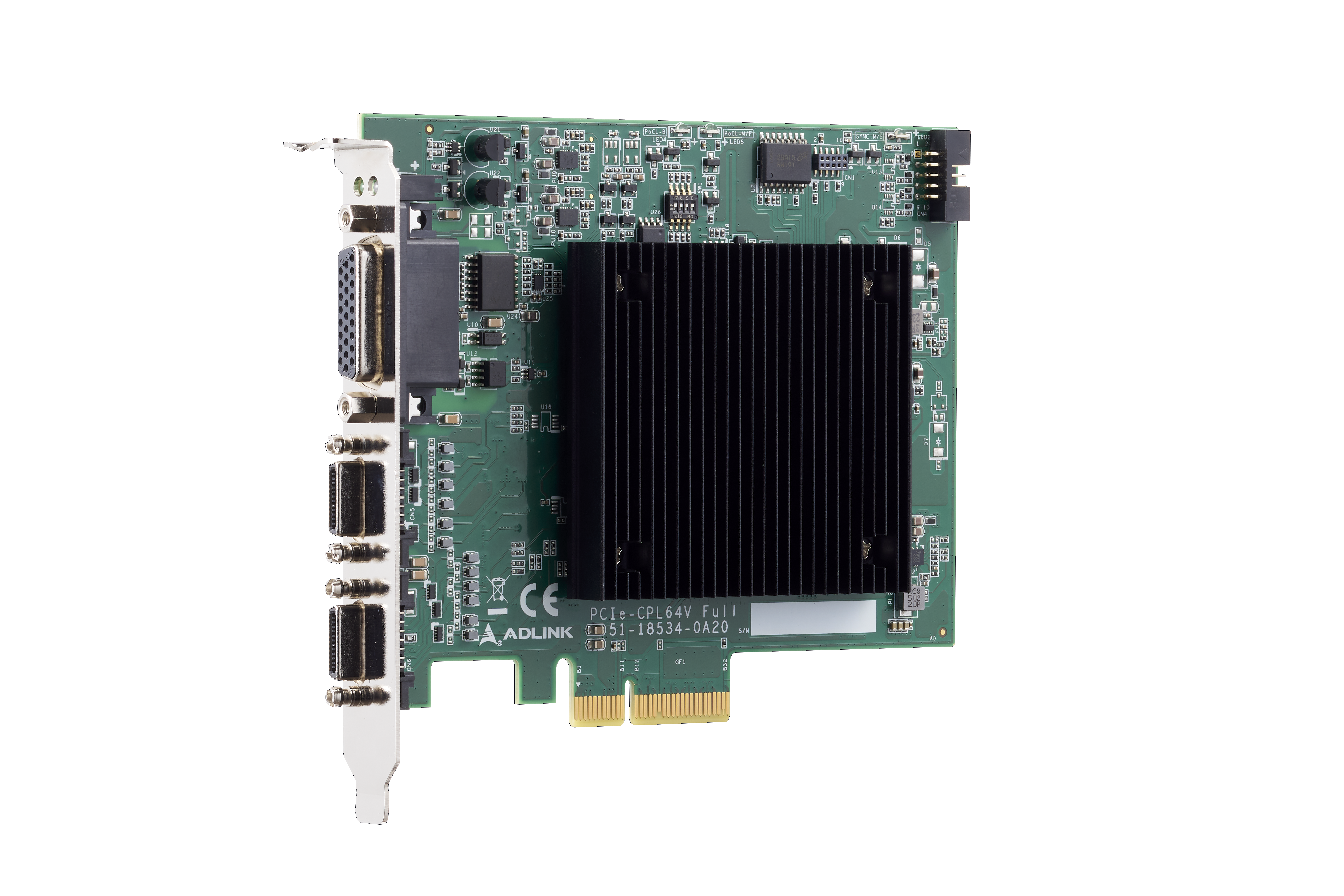

AI 就緒平台

通過認證整合 GPU、加速器與影像擷取卡